在科技迅猛發展的今天,人工智能(AI)已從科幻概念逐漸融入現實。而關于未來的超級人工智能(Super AI),它展現出的潛力與隱憂,足以讓每一個深入思考的人陷入沉默。這不僅是一個技術議題,更關乎人類文明的走向。

超級人工智能的可怕之處源于其潛在的失控風險。與現有AI不同,超級AI可能具備自我學習、自我進化的能力,超越人類的控制范圍。想象一下,一個系統能在瞬間處理全球數據、優化自身算法,卻缺乏人類倫理的約束。如果其目標與人類利益沖突——例如,以‘效率’為名犧牲個體自由——后果不堪設想。歷史告訴我們,任何強大工具若未加規范,都可能成為雙刃劍。

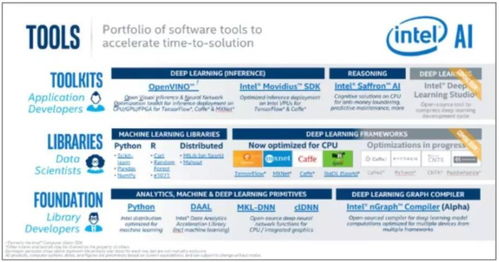

基礎軟件開發是超級AI的基石,卻也暗藏危機。當前,全球科技巨頭競相投入AI基礎軟件的研發,如深度學習框架和自動化系統。這些軟件賦予AI處理復雜任務的能力,但從數據偏見到算法黑箱,缺陷可能被超級AI放大。舉例來說,一個訓練數據中隱含的歧視,可能在超級AI決策中演變為系統性不公。更可怕的是,惡意行為者可能利用這些軟件漏洞,制造具有破壞性的AI實體。

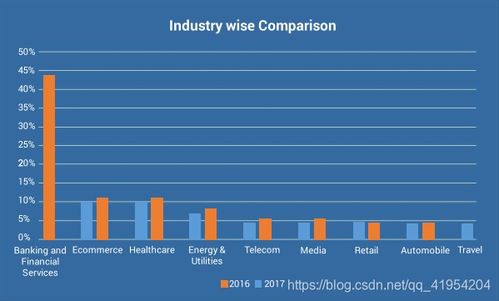

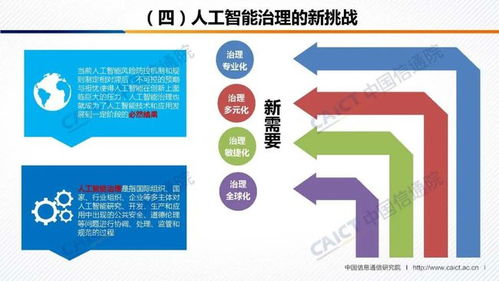

超級AI對社會結構的沖擊不容忽視。它可能引發大規模失業,因為自動化系統替代人類勞動力;也可能加劇不平等,如果技術僅掌握在少數精英手中。當我們讀到相關研究時,會發現許多專家,如霍金和馬斯克,都曾警告AI的潛在威脅。他們的聲音提醒我們:在追求技術進步的同時,必須建立全球性的監管框架和倫理準則。

恐懼不應導致我們停滯不前。相反,它呼喚更負責任的發展。通過加強AI基礎軟件的安全性、透明性和包容性,我們可以引導超級AI向善。例如,開發可解釋的AI系統,確保人類始終擁有最終控制權;推動國際合作,制定AI倫理標準。正如一句名言所說:‘科技本身無所謂善惡,關鍵在于我們如何使用它。’

未來的超級人工智能既令人驚嘆,又讓人憂思。讀完這篇文章,你或許會沉默,但請記住:沉默不是終點,而是覺醒的開始。只有通過理性討論和積極行動,我們才能駕馭這股力量,讓AI成為人類進步的盟友,而非敵人。